科技巨头马斯克近期的一则动态引起了业界的广泛关注——他宣布xAI旗下的Grok 2.5模型正式向公众开放源代码,并预告Grok 3将在半年后同样采取开源策略。

实际上,早在月初,马斯克就曾在社交媒体上预告称,Grok即将于下周开源。尽管实际开源时间略有延迟,但网友们普遍持宽容态度,认为“迟到总比没到好”。

此次开源的Grok 2.5包含42个文件,总容量高达500GB,用户已能在HuggingFace平台上下载。xAI官方推荐使用SGLang语言来运行该模型,并给出了详细的操作指南。

首先,用户需要下载权重文件。官方建议用户将文件保存在自己指定的文件夹中,例如/local/grok-2。不过,下载过程中可能会遇到一些错误,官方建议用户多次尝试直至成功。下载完成后,文件夹中将包含42个文件,总大小约为500GB。

接下来,用户需要启动推理服务器。xAI建议使用最新版的SGLang推理引擎(版本号需大于等于v0.5.1)。启动服务器的命令相对复杂,需要指定模型路径、分词器路径、线程数、量化精度以及注意力计算后端等参数。值得注意的是,该模型对硬件要求较高,需要8个显存超过40GB的GPU才能流畅运行。

最后一步是发送请求。由于Grok 2.5是一个预训练模型,用户需要确保使用正确的聊天模板。发送请求后,模型将回复其名称,即Grok。

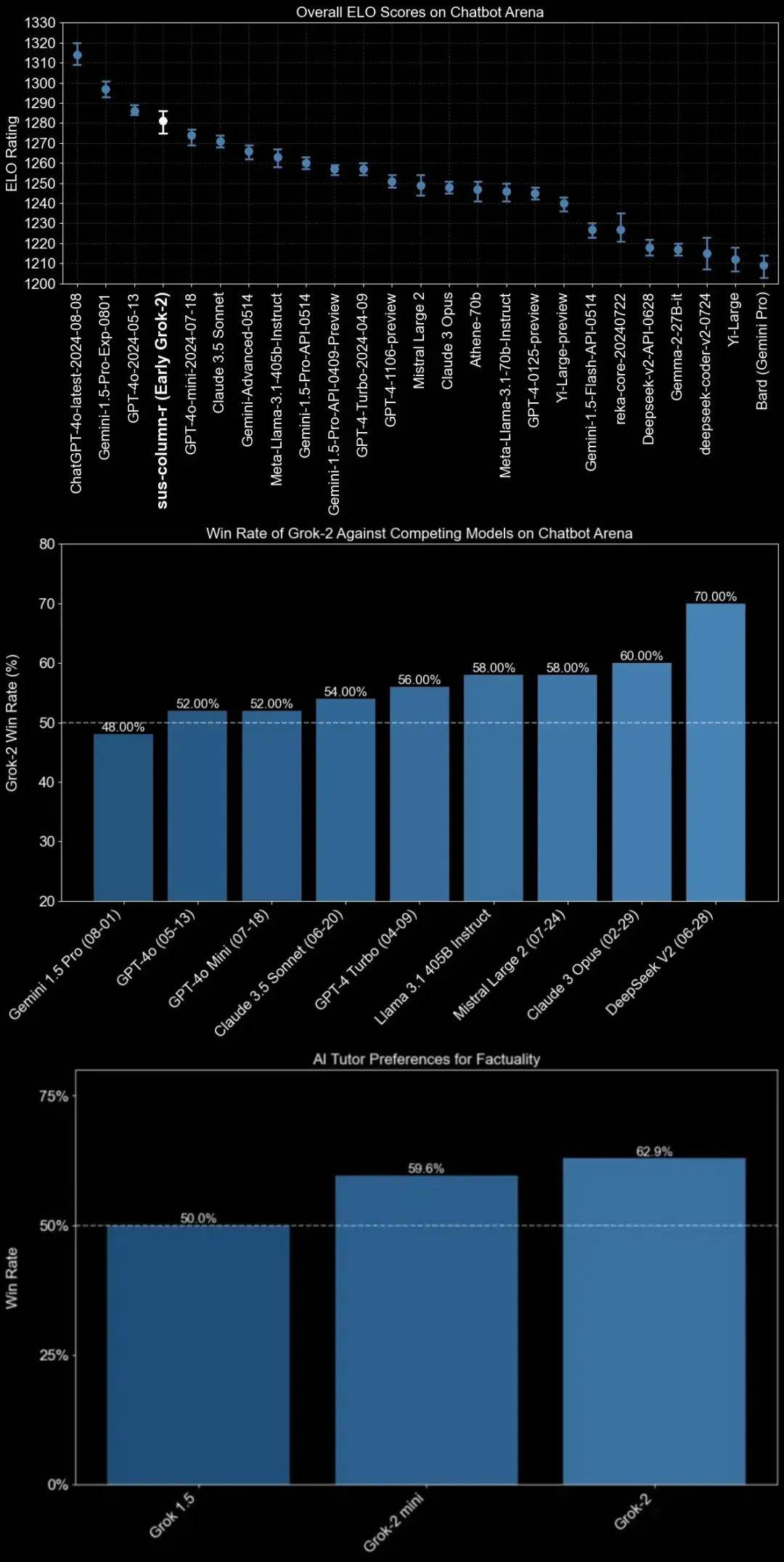

那么,xAI最新开源的Grok 2.5究竟实力如何?虽然它可能无法与当前的主流模型相媲美,但从去年xAI发布的技术博客中可以窥见一斑。当时,Grok 2在LMSYS排行榜上的总体Elo分数已经超越了Claude和GPT-4。

在一系列学术基准测试中,Grok 2系列在研究生级别科学知识、一般知识和数学竞赛问题等领域也展现出了与前沿模型相竞争的实力。

尽管马斯克开源的举动受到了广泛好评,但网友们也提出了一些质疑。例如,在HuggingFace平台上,xAI并未明确说明开源模型的参数权重,导致网友们只能根据以往信息猜测其为2690亿参数的MoE模型。开源协议的问题也引发了讨论,xAI在HuggingFace上的表述被网友解读为非商业许可,这与主流模型普遍采用的MIT或Apache 2.0许可有所不同。

最重要的是,运行该开源模型的硬件要求颇高,让不少用户望而却步。除了开源动作之外,马斯克还宣布了Grok APP的新功能更新,主要集中在AI视频生成方面,效果令人期待。

马斯克还发表了一段有趣的言论,称xAI很快就会超越谷歌,但最大的竞争对手将是中国公司。