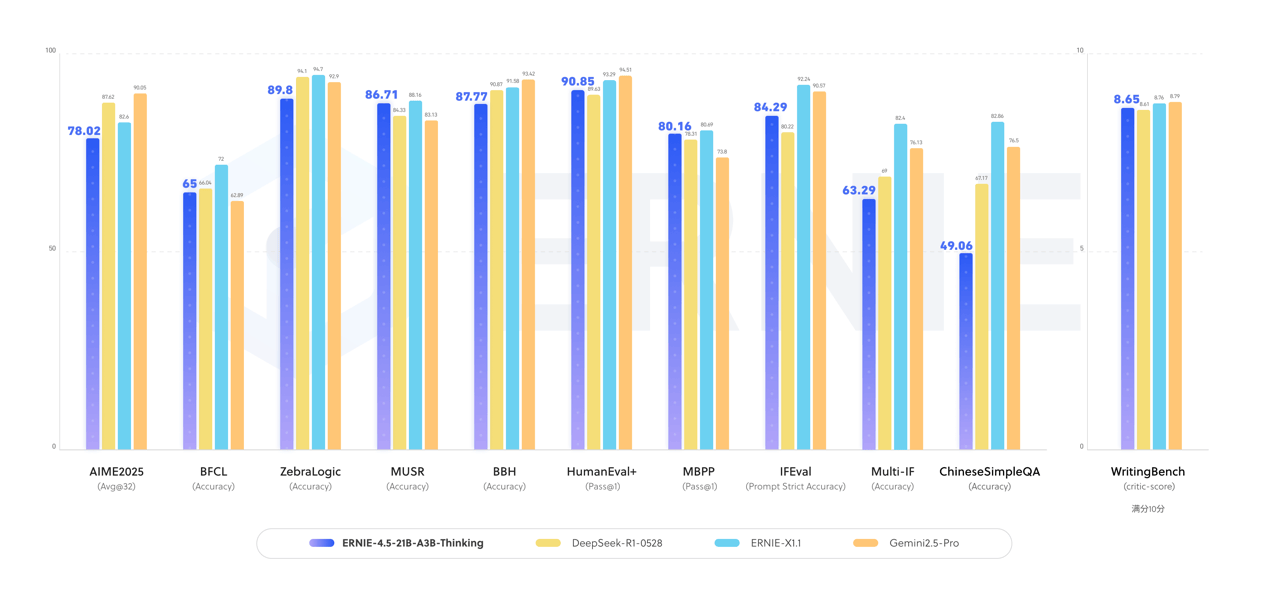

在WAVE SUMMIT深度学习开发者大会2025现场,百度宣布开源新一代深度思考模型ERNIE-4.5-21B-A3B-Thinking,引发行业广泛关注。这款基于混合专家架构(MoE)构建的模型,总参数规模达210亿,通过动态激活30亿参数的子网络实现高效推理,在逻辑推理、数学计算、科学分析等需要专业知识的领域展现出显著性能提升。

技术团队透露,该模型在ERNIE-4.5-21B-A3B基础上进行深度优化,通过指令微调与强化学习相结合的训练方式,显著增强了工具调用能力。其128K的上下文窗口长度,可支持需要长文本理解的复杂推理任务,在代码生成、多轮对话等场景中表现尤为突出。目前,FastDeploy、vLLM、Transformers等主流开源框架已实现对该模型的完整支持。

开源生态建设方面,百度采用Apache License 2.0协议开放模型使用权,允许商业场景下的自由应用。HuggingFace模型库与星河社区同步上线了完整版本,开发者可通过预训练权重与推理代码直接部署。这种全链条开源模式延续了百度6月30日发布文心大模型4.5系列时的策略,当时发布的10款模型(涵盖47B/3B MoE架构及0.3B稠密模型)已形成行业影响力。

同期发布的文心大模型X1.1深度思考版,在事实准确性、指令响应度及智能体协作能力上实现突破性进展。该模型通过文心一言官网、文小言APP向公众开放,企业用户可通过百度智能云千帆平台获取完整服务。技术文档显示,X1.1在医疗咨询、法律文书生成等垂直领域展现出专业级应用潜力。

行业分析师指出,百度此次双模型发布标志着大模型技术进入"深度思考"与"场景落地"并重的新阶段。ERNIE-4.5-21B-A3B-Thinking侧重复杂任务自动化处理,文心X1.1则强化垂直领域专业能力,二者形成技术互补。开源社区的快速响应显示,开发者对高效能、低门槛的AI工具存在持续需求。