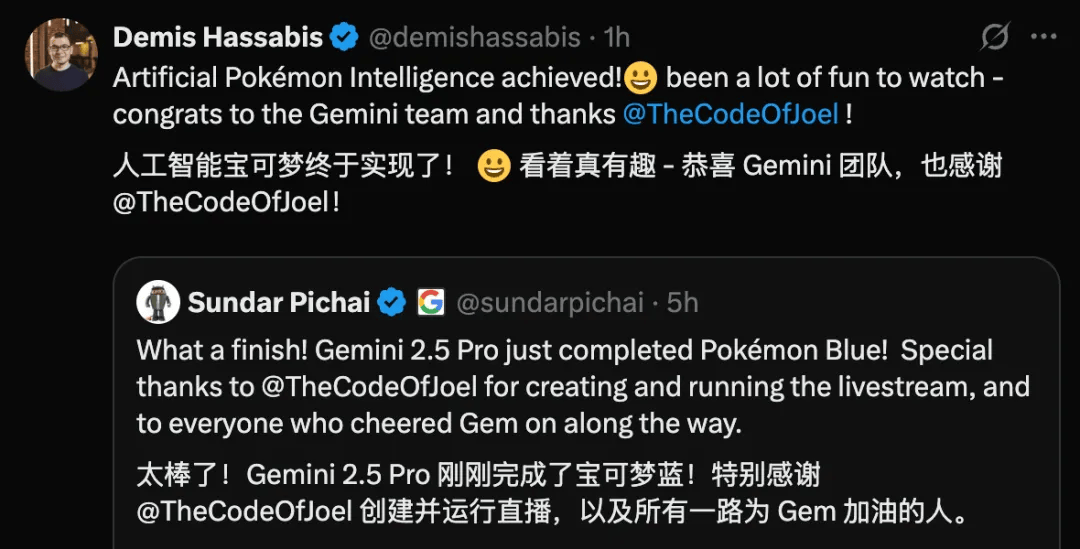

在人工智能领域,一个新的里程碑事件引发了广泛关注:谷歌的AI模型Gemini 2.5 Pro成功独立通关了1995年发售的初代《宝可梦》游戏。这一成就不仅让科技巨头谷歌的现任CEO Sundar Pichai和DeepMind负责人Demis Hassabis在社交平台上发文庆祝,也让整个AI界为之振奋。

《宝可梦》这款以休闲轻松为主的游戏,对于人类玩家来说,通关并非难事。然而,对于AI来说,这一挑战却远比想象中复杂。事实上,就在今年早些时候,另一家AI科技公司Anthropic也曾尝试让旗下的AI模型Claude 3.7 Sonnet体验初代宝可梦游戏,并以通关为目标。然而,经过一年的反复迭代,Claude的最终进度仅停留在挑战了三个道馆、获得三枚徽章的阶段。

那么,为什么让AI通关《宝可梦》会成为一件大事呢?这背后涉及到一个被称为“莫拉维克悖论”的反直觉观点:人类觉得容易的任务对人工智能来说其实更困难。对于这次Gemini通关《宝可梦》的事件来说,它更接近于让AI拥有自己的感知和行动力,这是一个比人类想象中要复杂得多的挑战。

与之前在围棋、《DOTA2》等项目中表现出色的AI不同,Gemini和Claude这类基于大语言模型的AI并未接受针对某款特定游戏的训练。它们没有被告知《宝可梦》的游戏规则或目标指令,而是直接让通用的AI模型操作游戏。这更类似于让一个对宝可梦游戏完全没有概念的纯新手通过自己的感知和学习来逐步掌握游戏。

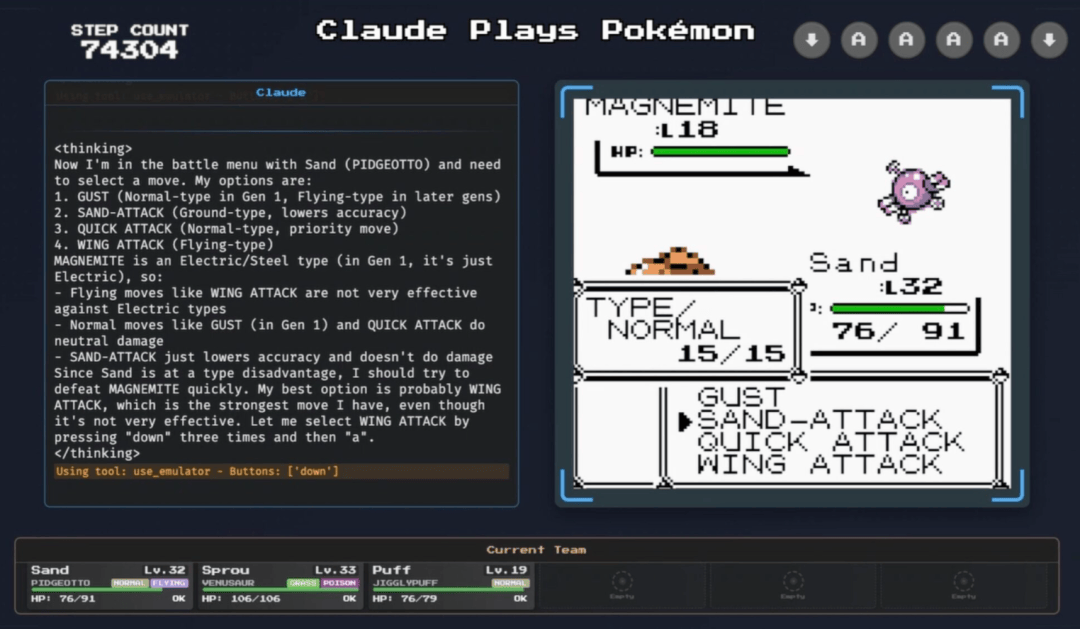

在这个过程中,AI需要为画面中的每一个坐标点标注信息,识别出哪些区域是可通过的,哪些是不可通过的。尽管宝可梦的属性克制系统对人类玩家来说可能有些复杂,但对于AI来说却相对容易理解。例如,当游戏提示电属性技能对岩石系宝可梦的“效果一般”时,AI能够迅速捕捉到这一关键信息,并将其应用到后续的配队和宝可梦对战策略上。

更令人惊奇的是,现在的大语言模型已经能够将完整的思考过程同步呈现给外界。当Claude在玩宝可梦时,它的每一步操作都会伴随着决策过程的同步显示。这不仅让人类能够更直观地理解AI的决策逻辑,也为AI的进一步改进提供了可能。

值得注意的是,尽管Gemini在通关过程中展现出了出色的智能水平,但据官方统计,它的总操作步数约为10.6万次,这比Claude获得第三个徽章时的21.5万步要少一半。然而,这并不意味着Gemini的智能水平就一定优于Claude。因为这两个AI是在不完全相同的条件下进行测试的,特别是它们所使用的“代理执行框架”存在差异。

代理执行框架的作用是连接AI模型与游戏,负责处理输入的信息并将模型的决策转化为按键指令等操作。从官方公布的信息来看,Gemini的代理执行框架在某些方面的确优于Claude,比如在对地图的分析上。它不仅为每个区域标注了坐标,还注明了坐标的可通行状态,这对于不擅长直接解析像素画面的大语言模型来说提供了巨大的帮助。

不过,让AI玩宝可梦的意义并不在于对比不同AI的水平高低。更重要的是,这类游戏需要AI具备感知环境、理解模糊目标以及长线规划行动的能力。它必须不断接收游戏画面、理解不同阶段的规则,并将决策转换为游戏操作。如果AI能够在人类没有干预的情况下通关这类游戏,那么它就具备了独立学习并解决现实中某些复杂问题的潜力。

从早年的围棋到现在的《宝可梦》,AI在实验和展示能力方面的逐年演变不仅吸引了大众的关注,也一定程度上代表了这项技术的发展方向:从处理单一问题的专才到能够自我学习、解决不同领域问题的通用人工智能。或许这正是众多AI科技公司选择《宝可梦》作为训练对象的原因:这款游戏本身便是关于成长、选择与冒险的旅程。而现在,AI正在游戏中尝试理解世界的规则本身。