在上海,一场聚焦金融AI推理应用的盛会于8月12日隆重举行。此次论坛——2025金融AI推理应用落地与发展论坛,汇聚了众多行业精英,共同探讨AI推理的最新进展和未来趋势。

论坛上,华为公司数据存储产品线总裁、副总裁周跃峰博士带来了一个令人瞩目的发布:UCM推理记忆数据管理器。这项技术被视为AI推理领域的创新突破,旨在通过优化推理过程中的数据管理,提升效率并降低成本。

UCM推理记忆数据管理器是一套以KV Cache为核心的推理加速解决方案。它集成了多种缓存加速算法工具,通过分级管理推理过程中产生的KV Cache数据,有效扩大了推理上下文窗口。这一创新设计不仅提高了推理的吞吐量和降低了时延,还显著减少了每Token的推理成本。

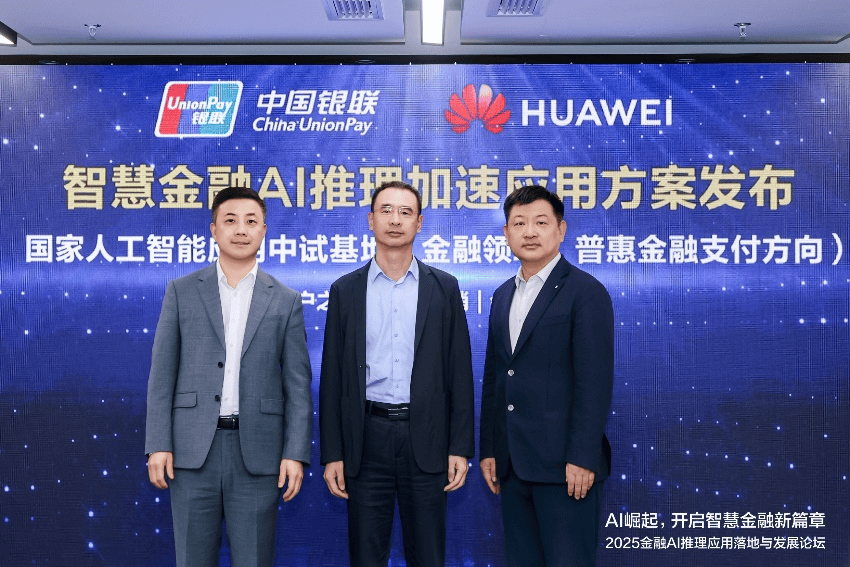

在金融领域,华为与中国银联率先开展了UCM技术的试点应用。双方联合发布了智慧金融AI推理加速方案的应用成果,展示了UCM在提升推理效率和降低成本方面的显著效果。周跃峰博士在论坛上强调,Token经济已经到来,AI推理的效率与体验成为关键。如何在推理效率与成本之间找到最佳平衡,是当前行业面临的重要挑战。

UCM推理记忆数据管理器由三大核心组件构成:推理引擎插件(Connector)、功能库(Accelerator)和高性能KV Cache存取适配器(Adapter)。这些组件通过推理框架、算力和存储三层的协同工作,实现了AI推理的“更优体验、更低成本”。具体而言,UCM通过层级化自适应的全局前缀缓存技术,避免了重复计算,显著降低了首Token时延。同时,UCM还将超长序列Cache分层卸载至外置专业存储,实现了推理上下文窗口的10倍级扩展,满足了长文本处理的需求。

在成本方面,UCM的智能分级缓存能力能够根据记忆热度在HBM、DRAM、SSD等存储介质中实现按需流动。UCM还融合了多种稀疏注意力算法,实现了存算深度协同,使长序列场景下的TPS提升了2-22倍,每Token推理成本显著降低。在中国银联的“客户之声”业务场景下,UCM技术的应用使得大模型推理速度提升了125倍,仅需10秒即可精准识别客户高频问题,有效提升了服务质量。

论坛现场,华为还正式公布了UCM的开源计划。UCM通过开放统一的南北向接口,可适配多类型推理引擎框架、算力及存储系统。预计在今年9月,UCM将正式开源,并逐步贡献给业界主流推理引擎社区。这一举措将推动AI推理生态的繁荣发展,促进技术创新与应用落地。