在AWS re:Invent全球大会上,亚马逊宣布其自研AI训练芯片Trainium系列已形成规模化商业效应。公司首席执行官Andy Jassy通过社交平台披露,基于第二代芯片Trainium2的业务年化收入突破十亿美元规模,目前有超过百万片该型号芯片处于生产阶段。这一数据标志着亚马逊在英伟达主导的AI加速器市场成功开辟出新的增长极。

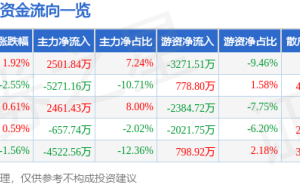

性价比优势成为客户选择的核心驱动力。Jassy强调,Trainium系列芯片在同等性能下较市场主流GPU方案成本降低40%-60%,这种差异化策略延续了亚马逊在云计算领域"硬件自研+服务整合"的经典模式。目前已有超过十万家企业将Trainium芯片应用于AI模型训练,其中亚马逊AI开发平台Bedrock的70%计算任务由该芯片承担,形成了从芯片到云服务的完整技术闭环。

战略级客户Anthropic的深度合作成为关键突破口。作为亚马逊重点投资的AI初创企业,Anthropic在其下一代Claude系列模型训练中部署了超过50万片Trainium2芯片。双方合作的"Project Rainier"项目构建了全球最大规模的专用AI服务器集群,该集群专门服务于Anthropic急剧扩张的算力需求。这种"投资换算力"的商业模式既为芯片业务提供了稳定订单,也通过实际应用验证了技术可靠性。

技术迭代持续加速追赶步伐。大会同期发布的第三代芯片Trainium3实现性能跃升,其计算性能、能效比和内存带宽较前代分别提升440%、400%和380%。但亚马逊面临的市场壁垒依然严峻——英伟达通过CUDA软件平台构建的开发者生态,使得迁移至非CUDA架构需要承担高昂的改造成本。据行业分析,重写现有AI应用代码的成本可能达到开发总投入的30%-50%。

针对生态壁垒,亚马逊正在筹备更具颠覆性的解决方案。知情人士透露,正在研发的第四代Trainium芯片将实现与英伟达GPU的硬件级协同工作,这种"混合架构"设计既保持了自研芯片的成本优势,又通过兼容CUDA生态降低客户迁移门槛。该策略若能成功实施,或将重塑云计算市场的竞争格局,但具体效果仍需观察实际部署情况。