阿里通义实验室近日宣布推出新一代基础模型架构Qwen3-Next,并同步开源基于该架构的Qwen3-Next-80B-A3B-Base模型。这款拥有800亿参数的模型仅激活30亿参数,在保持高性能的同时显著降低了计算资源消耗,其预训练数据规模达15T tokens,仅需Qwen3-32B模型9.3%的GPU算力即可完成训练。

在长上下文处理能力方面,Qwen3-Next系列模型原生支持262,144个token的上下文窗口,并可扩展至1,010,000个token。测试数据显示,其Base模型在超过32k token的长文本推理场景中,吞吐量达到Qwen3-32B模型的10倍以上。通过混合注意力机制与多Token预测(MTP)技术的结合,模型在4k token上下文下的预填充阶段实现近7倍吞吐提升,解码阶段提升近4倍。

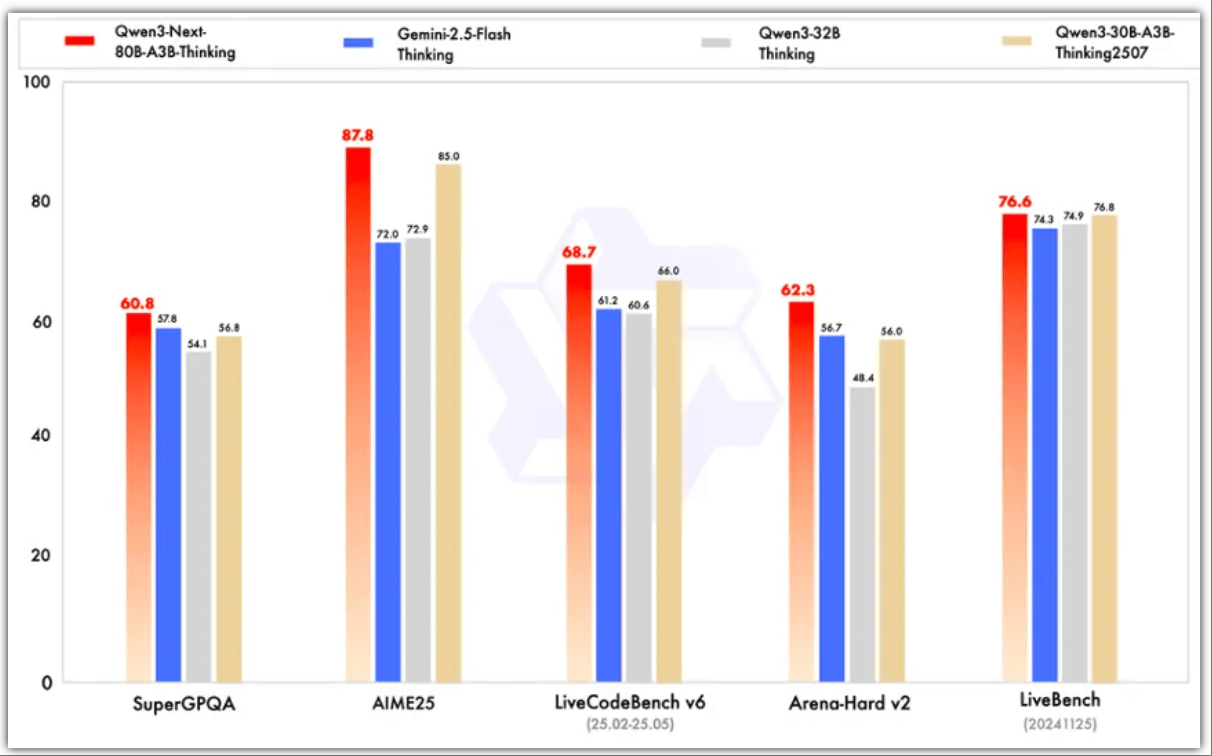

此次开源包含指令模型(Instruct)和思维模型(Thinking)两个变体。其中指令模型在RULER基准测试中,256k长度范围内的表现超越参数规模更大的Qwen3-235B-A22B-Instruct-2507;思维模型则在数学推理、复杂问答等任务中全面超越谷歌Gemini-2.5-Flash-Thinking,部分指标接近阿里最新旗舰模型Qwen3-235B-A22B-Thinking-2507。

架构创新方面,Qwen3-Next采用混合注意力机制,将75%的注意力层替换为Gated DeltaNet(线性注意力),25%保留标准注意力结构。这种设计使模型在保持标准注意力数值稳定性的同时,获得更强的长上下文建模能力。研究人员通过扩展注意力头维度至256、优化旋转位置编码等技术,进一步提升了模型对超长文本的处理效率。

在高稀疏度MoE(混合专家)结构方面,该模型实现了1:50的专家激活比率,较前代1:16的激活比显著降低计算开销。通过全局负载均衡机制,模型在专家参数持续扩展时仍能保持训练损失稳定下降。稳定性优化措施包括零中心化、权重衰减layernorm等技术,有效消除了注意力池化中的数值不稳定现象。

多Token预测(MTP)机制的引入,使模型在预训练阶段即可实现多步推理优化。测试表明,该技术将Speculative Decoding的接受率提升至实用场景所需水平,显著加速了推理过程。开发者在魔搭社区和HuggingFace平台的反馈显示,MTP机制是此次架构升级中最受关注的技术亮点。

目前,Qwen3-Next系列模型已在魔搭社区和HuggingFace开源,开发者可通过Qwen Chat或NVIDIA API Catalog体验模型能力。此次开源的模型变体包括:支持指令模式的Qwen3-Next-80B-A3B-Instruct,以及专注思维推理的Qwen3-Next-80B-A3B-Thinking,两者分别针对不同应用场景优化了输出模式。

性能对比数据显示,Qwen3-Next-80B-A3B-Base在多数基准测试中达到Qwen3-32B-Base水平,但训练成本不足其10%。在AIME25数学推理基准中,指令模型虽略逊于2350亿参数的旗舰模型,但在编程、复杂问答等任务中表现更优。思维模型在MMLU、BBH等综合性评测中,全面超越预训练成本更高的Qwen3-30B-A3B-Thinking-2507。